FramePack:ControlNet作者新作,6GB显存即可本地运行AI视频生成

Stable Diffusion 想必大家都不陌生,而它的重要插件 ControlNet 更是许多AI绘画爱好者的必备工具。现在,ControlNet 的作者 lllyasviel 再次带来惊喜,开源了全新的 AI 视频生成算法 FramePack。

令人惊艳的生成效果

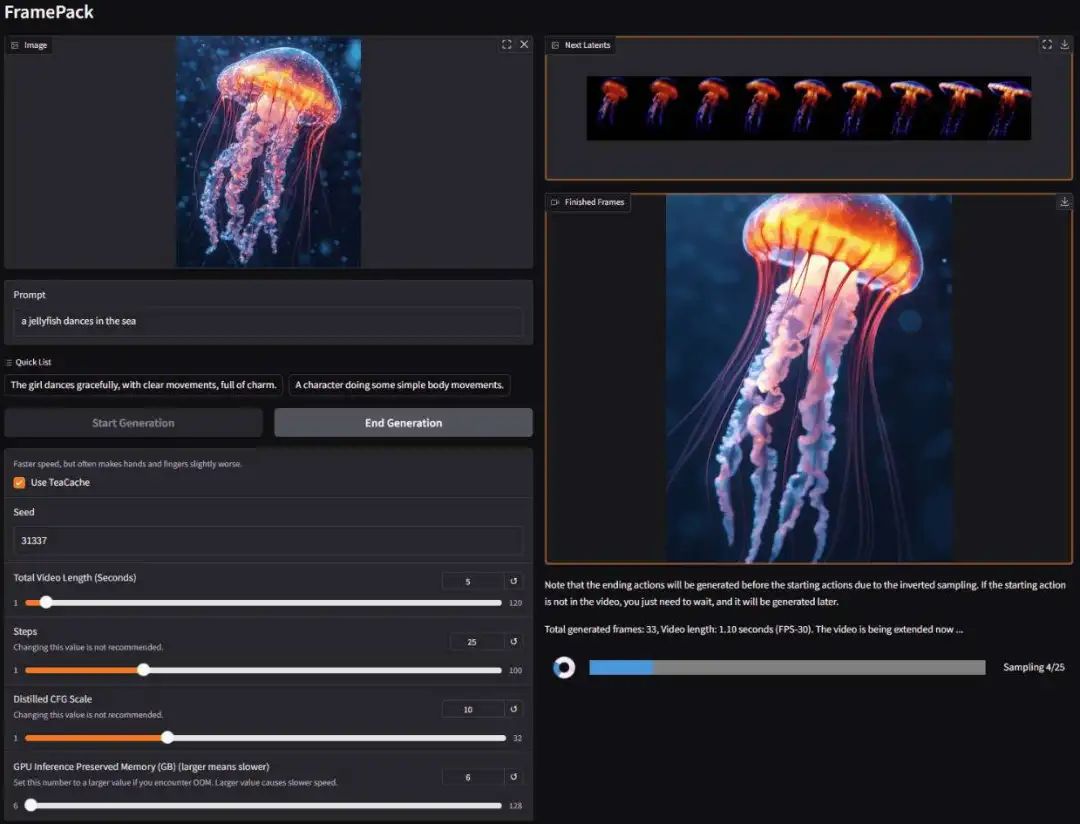

FramePack 能够根据单张图片生成对应的动态视频。比如这张静态的水母图片:

只需要上传图片并输入提示词:

The girl dances gracefully, with clear movements, full of charm.

就能得到流畅的舞蹈视频。FramePack 的其他生成效果同样令人印象深刻:

- 5秒长的古画动画

- 2分钟长的赛博朋克2077宇宙场景

- 1分钟长的花样舞蹈视频

突破性的性能表现

最令人惊喜的是其硬件需求的大幅降低。以往生成类似质量的视频通常需要多张A100显卡协同工作,而FramePack仅需:

- 搭载6GB GPU显存的RTX 3060笔记本

- 个人版RTX 4090可达2.5秒/帧生成速度

- 经teacache优化后可达1.5秒/帧

技术原理与创新

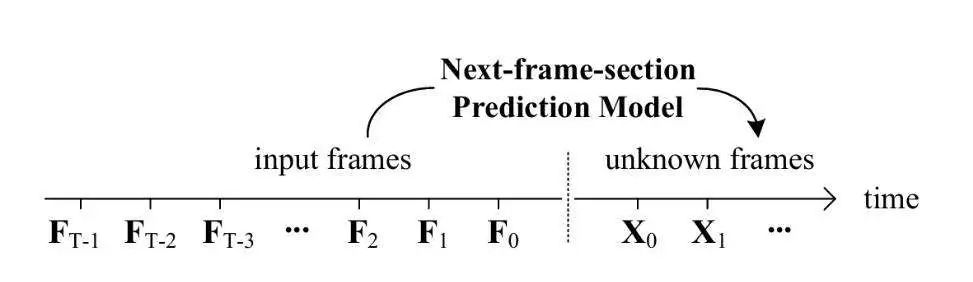

FramePack是由斯坦福大学的Lvmin Zhang(ControlNet作者)和Maneesh Agrawala联合开发的next-frame预测神经网络。其核心技术亮点包括:

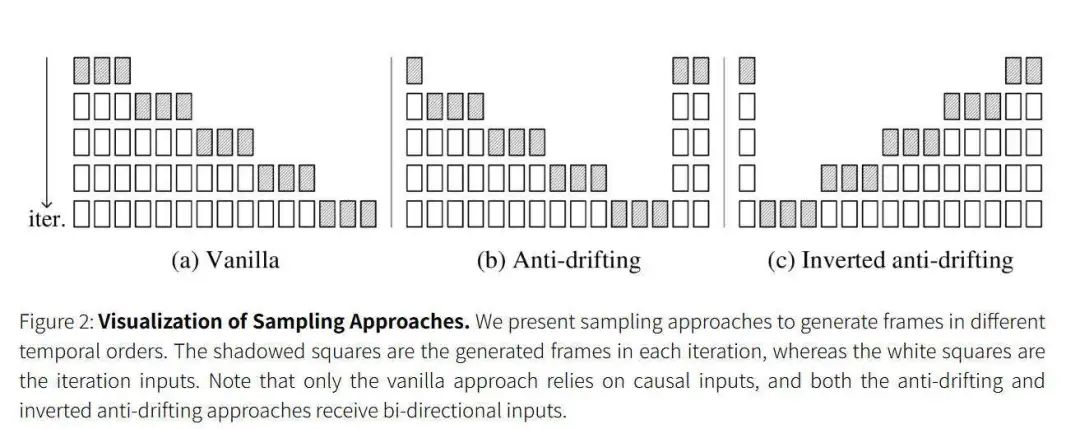

-

智能帧压缩技术

根据帧的重要性采用不同压缩模式,显著降低GPU显存需求。 -

反漂移采样方法

特别设计的第三种采样方法将用户输入视为高质量首帧,持续优化后续帧质量。 -

实时预览功能

用户可即时查看每一帧生成效果,不满意可随时停止,避免长时间等待。

安装与使用指南

Windows系统

- 下载发布包:

https://github.com/lllyasviel/FramePack/releases - 解压后运行update.bat更新

- 使用run.bat启动程序

Linux系统

建议使用Python 3.10环境:

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu126

pip install -r requirements.txt

python demo_gradio.py操作界面

- 左侧上传图像和输入prompt

- 右侧显示生成视频

- 实时显示生成进度和预览

项目信息

- 项目主页: https://lllyasviel.github.io/frame_pack_gitpage/

- 代码仓库: https://github.com/lllyasviel/FramePack

FramePack的出现标志着AI视频生成技术向大众化迈出了重要一步,让更多人能够以极低的硬件成本体验AI视频创作的乐趣。这项技术不仅是对现有AI视频生成方案的突破,更为未来的创作方式开辟了新的可能性。

这一切,似未曾拥有